从英伟达要“一次解决所有模型问题“的GEAR,到成立两年就估值破25亿美元的机器人OpenAI Figure,2024年才刚开局机器人领域已经变得疯狂。今年已经被很多人预言为“机器人元年”。而华语圈刷屏最多的,还是不久前因一段50秒演示视频风靡全网的斯坦福「Mobile ALOHA」全能家务机器人。

视频中,这个带轮子的双臂机器人能自主按电梯、擦拭红酒杯、与人类击掌、把凌乱的椅子归位,还能像厨师一样倒油翻面煎炸虾仁,然后再顺带把锅给洗了放柜里。聪明能干程度让大家看后惊呼,也许从此就可以解放双手耍废,妥妥一个通用智能管家。

它还能借助远程操控系统,由用户同时控制底座和两个机器手臂来完成更多样的任务。像是浇花、地毯吸尘、使用咖啡机、丢垃圾、洗衣服、叠被铺床套枕套、从冰箱取出番茄酱并挤好在盘里、甚至帮助剃须和逗猫。虽然是遥控操作,但呈现出的动作顺畅和精细程度仍令人印象深刻。

用 Transformer 的思路解机器人题

根据项目团队介绍,「Mobile ALOHA」实际是他们在去年3月发布的ALOHA系统基础上做的移动性和远程界面强化。主要技术原理就是通过模仿学习和团队基于神经网络模型Transformer开发的动作分块算法 ACT(Action Chunking with Transformers),来执行复杂的移动操作任务。

正如自然语言处理技术的变革,让大模型通过海量的互联网数据学习来直接推理预测回复,团队也思考着如何把这一全新范式应用到机器人技术环境中。ACT算法的本质正是这样一个端到端的策略:直接把现实世界的RGB图像映射到动作,让机器人从视觉输入中学习和模仿执行特定的动作,而无需额外人工编码的中间表示。同时采用动作分块方法(Chunking),预测在当前观察下人类操作员会执行的动作序列,集成准确而平滑的动作轨迹。

不过和语言模型不同的是,对LLM来说,历史信息至关重要。ChatGPT和Gemini都需要从上下文里推断合适的答案。而机器人环境中的训练数据有限,对动作的学习模仿更像是一种本能,因此团队目前选取的任务并不需要理解历史背景。

这也能解释演示视频中话题度最热的“自主炒虾”环节。一次线下分享中,观众提问Mobile ALOHA是“如何判断什么时候该翻面,什么时候虾熟了”,简言之,它怎么控制烹饪时间?

而团队成员赵子豪则透露了这样一个小秘密,“为什么用虾仁做食材呢?因为虾在烹饪时会变色,这就是我们想要利用的一个视觉提示。这种选择是基于当前算法可以识别和处理的任务,而不必依赖于广泛的上下文数据。”

同时他也认为,像OpenAI 的Sora模型或任何形式的大规模预训练,都会有益于机器人技术。他举例说在一个对象是透明杯子的任务中,把杯子换成蓝色可能就无法成功了。然而将互联网预训练与机器人数据集结合起来,或许就能得到改善。

“世界模型中捕获的一些通用知识可能会告诉机器人,无论杯子是蓝的、红的还是透明的,操纵方法都一样。我们期待从像Sora这样的世界模型中获得泛化能力的提升。”

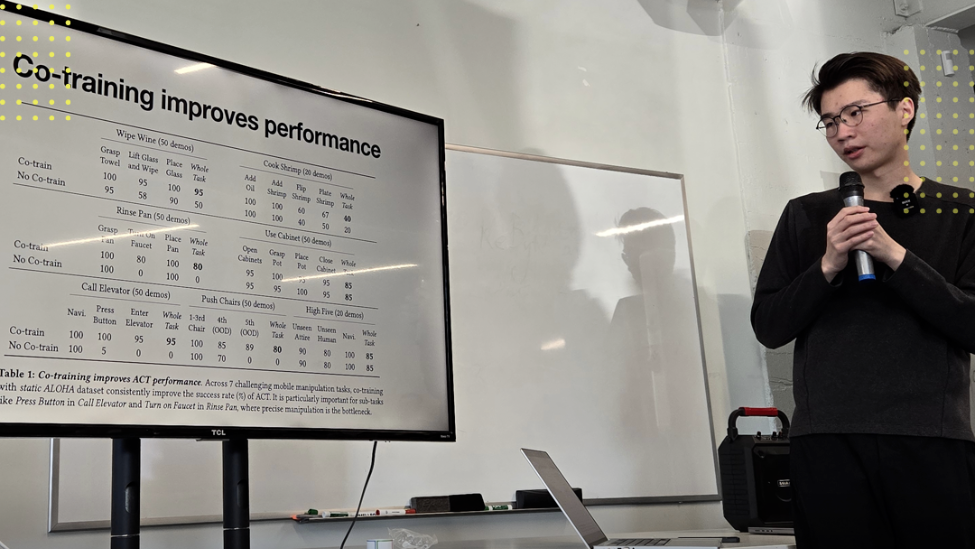

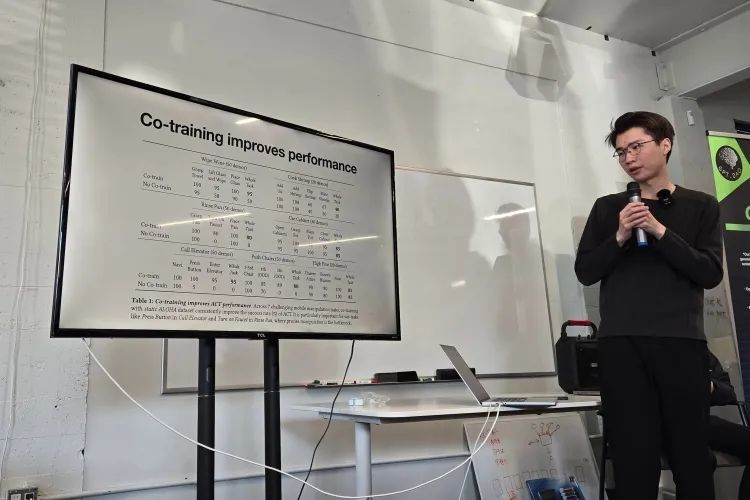

赵子豪 (Tony Z. Zhao)在线下AI活动做分享

项目的另一个亮点是协同训练(co-training),即使用现有的静态ALOHA数据集(包括从黑色桌面上收集的825个演示)和Mobile ALOHA项目中新采集的移动示教数据来共同训练机器人。

在协同训练下,每项任务只需要观看50次人类演示,就能将成功率提高到90%,显著提升了机器人执行复杂双手移动任务的技能和效率。

复杂的机器人不用非得贵,开源一切给大家“再创造”

除此之外令人惊喜的是,一台Mobile ALOHA机器人的成本仅需3.2万美元(约22万人民币)。并且软硬件包括深度学习代码全部开源,人人都可以依照教程,使用现成机器人零件和3D打印件自己搭建系统。这也正是ALOHA 给自己「A Low-cost Open-source Hardware System(低成本开源硬件系统)」名字的定义。

操作过程学起来也很简单。团队找来8名志愿者做测试,结果证明共计20分钟的五次尝试后,普通用户演示任务的时间就能与团队专家持平。

由斯坦福两名华人博士符梓鹏和赵子豪,以及导师Chelsea Finn组成的三人研发团队。项目页面地址:https://mobile-aloha.github.io/cn.html

赵子豪说,把ALOHA和Mobile ALOHA项目开源,就是因为做一个研究机器人学的博士生实在有点儿“痛”,市面上好用的机器人解决方案太少也太难,对许多任务来说也不够灵活。团队的初衷是构建一个可信赖的、适应更多通用任务的开发和研究平台,让人们“在我们工作的基础上创造更多东西出来”。

“我们离成为产品还相当遥远”

Mobile ALOHA展现出的惊艳效果令不少人呐喊“机器人商业化近在眼前”,可团队却紧接着给这股群情兴奋“泼了点儿冷水”,在社交媒体大方po出一则「ALOHA翻车合辑」:面对平放的记号笔抓瞎,握不紧杯子洒了一桌子红酒,拿不起炒锅还把油和虾仁直接倒在岛台上…

按照他们自己的说法,是希望公众先不要产生过于超前的预期,虽然可以通过遥操作让机器人自动去做很多任务,但它是否可以不犯错,和人比仍然有较大差距。“我们专门把过去1到2个月错误合成给大家看,这里还有很多未解决的挑战,希望更多研究者进入领域,让错误消失。也想表明研究过程不是一帆风顺的,要经历很多失误,修改代码、修改数据和模型,才能达到论文中的80%到90%的准确率。”

团队的坦诚反倒让网友称赞有加,有人表示“谢谢你们展示失败,让我保持清醒并认识到机器人真正到了哪一步。”也有人鼓励说“你们正为改变世界做自己的尝试,期待ALOHA的未来!”

研究论文中也透露了项目存在的一些局限性,例如底轮占地面积无法通过一些狭窄路径、机械臂动作自由度有限。以及至今尝试却无法成功完成的两个挑战性任务:剥开紧紧包裹的糖果包装,和打开封口闭合的塑料自封袋。在技术上也需要找到更可扩展的数据收集方法。

“我们离商业化实际上还相当遥远”,赵子豪在分享活动上说,“特别是如果要成为消费产品,你不可能只满足于80%的成功率,它需要更高得多。另一个重要的点是它需要更好的泛化能力——你买了一个新机器人,肯定不想重新收集所有任务演示,对吧?因此距离真正可靠和强大的家用机器人我们还很远,绝对是。”

Mobile ALOHA机器人在发布后曾引发广泛关注,以其流畅精准地执行复杂任务掀起了极高的话题度。之后主动呈现瑕疵又让人们说它看上去“愚蠢又可爱”。而这一研究本身的重要性尚未被充分讨论。

因此,我们最近跟项目作者之一的赵子豪在硅谷做了一次交流,针对更多层次进行了探讨。

赵子豪目前是斯坦福大学博士生和 Google DeepMind兼职研究员,研究重点是端到端的精细机器人操控。他也曾在特斯拉实习期间担任机器学习科学家。

以下是他和硅星人的对话实录:

硅星人:为什么最近机器人领域突然火热了起来,GEAR,Figure都是大事件,包括Mobile ALOHA,从业内人士来看,是因为哪些具体的技术能力出现了突破么?这些突破是如何发生的?还是更多因为AI的热潮溢出到了机器人领域?

赵子豪:现阶段manipulation一个很大的突破在模仿学习。去年的Diffusion Policy、ALOHA/ACT 是比较有代表性的成果。突破点在于(1)学界有了收集高质量数据的方法 。(2)发现生成建模技术在机器人领域能运用的很好。同时在机器人运动控制领域sim2real (仿真到现实)也有了非常大的进展。总的来说我会觉得AI的进步启发了机器人的进步。

硅星人:AI领域目前有LLM和世界模型的路线之争,有Transformer和Diffusion潜在的争夺与融合,在机器人领域有哪些主流的技术路线和方案?你更倾向哪一条路线?

赵子豪:在机器人领域有传统的感知+规划方法,也有比较激进的端到端学习方法。举个例子,特斯拉FSD v12之前采用的是传统方法,之后改为了端到端学习。我倾向于将端到端的模仿学习用于操作,将端到端的强化学习、模拟到真实用于运动控制。

硅星人:有人形容AI越来越像是一个“用不同新名词描述同一个旧概念”的游戏,机器人领域似乎也有这样的现象,“具身智能”、“通用智能体”等时髦的概念出现,但机器人技术的演进是有自己的历史和基础理论的,这是否会带来影响?事实上今天机器人技术主要在解决和攻克哪些问题?

赵子豪:其实这些都不是新名词,一直有人在用。我觉得有意思的点是这些名词更突出“智能”,而不是“机器”。这其实是机器人社区一个观念上的转变,大家意识到intelligence可能比“去为特定任务设计一个末端执行器”更加重要。

硅星人:看到你的个人简介里写着对start up感兴趣,而你同时也在谷歌和特斯拉这样的大厂工作过,你认为机器人领域还会有自己的“OpenAI”么,还是最终会由大厂主导?尤其是最近从英伟达到Figure都体现出来明显的资源和资本的聚拢,初创公司还有机会么?

赵子豪:我相信任何领域永远都有创业公司的机会。Startups can be nimble, focused, and fast-executing.

硅星人:Mobile ALOHA最重要的意义是低成本,还是它体现出来的处理现实世界数据的雏形,还是一个可以适配不同的模仿学习算法的底层系统平台?

赵子豪:Mobile ALOHA 是一个验证概念性的家用机器人, 设计初衷是研究平台。对我来说它的意义在于 (1) 证明模仿学习在移动操作中的可行性 。(2) 开源软硬件促进接下来的算法研究。

硅星人:Mobile ALOHA的相关研究都给我一种感觉,就是你们追求尽可能的简洁。这是因为现在机器人的相关技术到了收敛的阶段,还是你们想要先提供一个更简洁的样本给技术社区?

赵子豪:我非常信奉Elon的 “The best part is no part.” 和Richard Sutton的bitter lesson,最能利用数据和计算的算法往往是简洁的。语言建模中的“下一个标记预测”技术就是一个很好的例子。当然,去真正产品化Mobile ALOHA还是会需要很多工程细节。这篇paper只是一个雏形。

硅星人:从Mobile ALOHA来看,机器人的数据收集和动作训练学习,以及动作执行是不是基本上同时进行的?你提到训练数据现在是个难题,过往自动驾驶使用大量模拟数据,今天各种大模型训练里也开始讨论合成数据的可行性,这些对解决机器人的训练数据问题有什么启发?

赵子豪:从数据收集到部署需要几个小时的模型训练时间。模拟器仿真到现实(sim2real)对于运动控制已经有了很大的帮助,但对于模拟接触丰富、可变形物体的操作仍然需要模拟器上的进步。

硅星人:接下来你最期待的机器人领域或者泛人工智能领域的技术突破是什么?

赵子豪:期待一个和state-of-the-art相似的开源视觉语言模型。这对于学界机器人研究会有很大帮助。

硅星人:你自己接下来有什么计划,有什么可以提前剧透的么?

赵子豪:模仿学习在灵巧性的上限非常高,请期待接下来更多在ALOHA上的工作!

一切刚刚开始

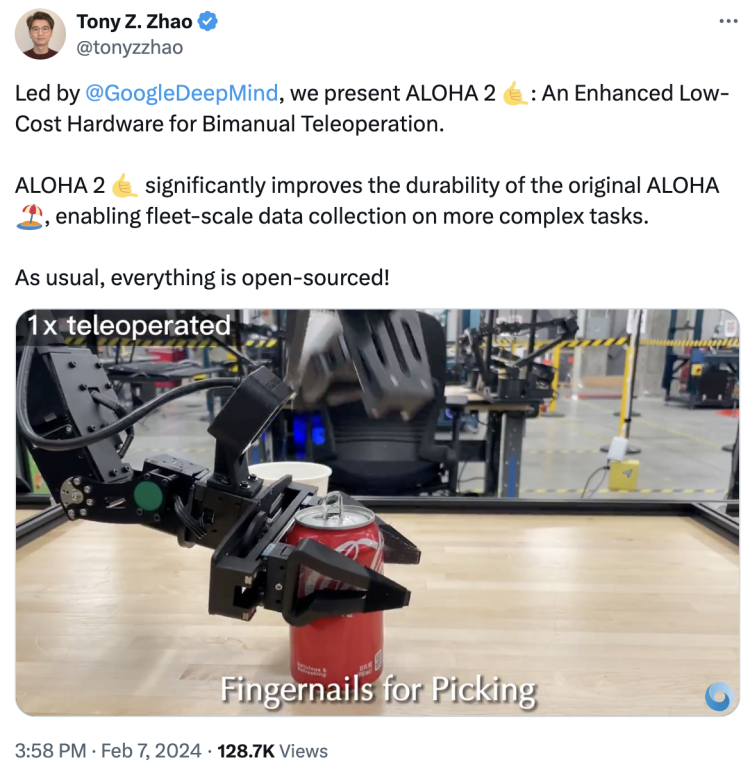

上个月,赵子豪/符梓鹏领导的斯坦福项目团队联合Google DeepMind和Hoku Labs,推出了升级版本的ALOHA 2。与上一代相比,二代显著提高了耐用性️,能够在更复杂的任务上实现大规模数据收集,性能也更强,能完成拉起可乐拉环这样的精细动作。成本低于20万元人民币,而且继续开源。

赵子豪也在活动上分享,在接下来几个月,也许很快,大家就会看到新的项目成果。我们有理由推测,它会设计更精巧、更用户友好,被训练的更为灵活,也能完成更多意想不到的高难度任务。

两位年轻的研究者欣喜地看到,随着AI技术发展,机器人行业正越来越多地将模仿学习作为底层原则。初代Mobile ALOHA机器人也许并不完美,但它一直在算法、技术和工程上努力尝试,并且已经实现诸多令人惊喜的突破。

模仿学习灵巧性的上限是什么,机器人能力的边界在哪里?他们希望ALOHA能成为专业研发人员共同探索的开源平台,沿着这个方向,就会有更多可能被创造出来。

请登录后查看回复内容